- 144개 칩 확장·4배 효율성 향상…대규모 AI 모델 훈련 기간 대폭 단축

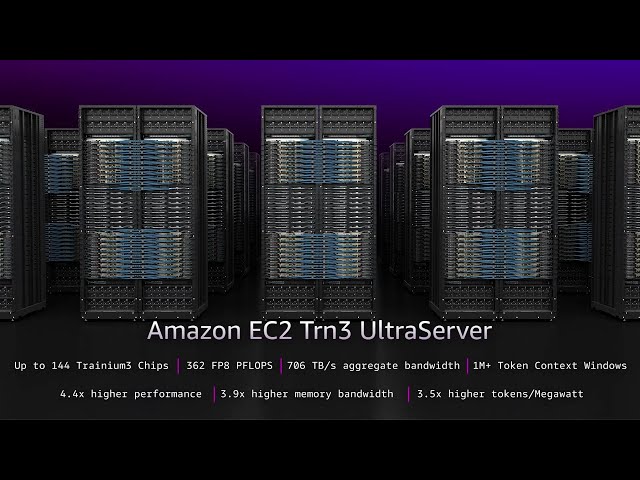

AWS는 AWS 리인벤트 2025에서 3나노미터 공정 기반 트레이니움3(Trainium3) 칩을 탑재한 ‘아마존 EC2 Trn3 울트라서버(Amazon EC2 Trn3 UltraServers)’를 공식 출시했다고 밝혔다. 이를 통해 기업은 대규모 AI 모델을 더 빠르게 훈련하고 더 많은 사용자에게 낮은 비용으로 서비스를 제공할 수 있는 고성능 인프라를 확보하게 된다.

144개 칩 확장 지원…차세대 AI 모델 위한 컴퓨팅 설계

Trn3 울트라서버는 최대 144개의 트레이니움3 칩으로 확장이 가능하며, 최대 362PFLOPs(평가 기준 FP8) 성능을 제공한다. 이전 세대 대비 4.4배 향상된 컴퓨팅 성능, 4배 높은 에너지 효율성, 4배 넓은 메모리 대역폭을 제공해 모델 훈련 기간을 몇 달에서 수 주로 단축한다. GPT-OSS 기반 테스트 결과, Trn2 대비 칩당 처리량은 3배, 응답 속도는 4배 향상된 것으로 확인됐다.

네트워크 병목 제거한 트레이니움3 전용 패브릭 구조

AWS는 칩 아키텍처부터 소프트웨어 스택까지 수직 통합된 구조를 적용했다. 새로운 뉴런스위치-v1은 울트라서버 내부에서 2배 대역폭을 제공하며, 통신 지연을 10마이크로초 미만으로 줄인 뉴런 패브릭은 대규모 분산 AI 훈련의 병목을 제거하는 역할을 한다.

EC2 울트라클러스터 3.0은 수천 대의 Trn3 울트라서버를 연결해 최대 100만 개 트레이니움 칩을 활용할 수 있는 인프라를 구성한다.

고객 사례 기반 비용 절감 효과 입증

앤트로픽, 카라쿠리, 네토닷에이아이, 리코 등 고객사는 트레이니움을 활용해 훈련 비용을 최대 50% 절감했다고 밝힌 바 있다. AI 영상 생성 기업 디카트는 GPU 대비 절반 비용으로도 4배 빠른 프레임 생성 성능을 확보해 실시간 인터랙티브 콘텐츠 구현 범위를 확대하고 있다.

아마존 베드록은 이미 트레이니움3 기반 프로덕션 워크로드를 운영 중이다.

트레이니움4 개발 착수…FP8 성능 3배 향상 목표

AWS는 차세대 ‘트레이니움4’ 개발에 돌입해 FP4 성능 6배, FP8 성능 3배, 메모리 대역폭 4배 강화를 목표로 하고 있다. NV링크 퓨전 기반 고속 연결 기술을 지원해 트레이니움4·그래비톤·EFA 기반 인프라를 단일 MGX 랙에서 구성할 수 있도록 설계 중이다.

#AWS #Trainium3 #Trn3울트라서버 #EC2UltraCluster #AWSAI #NeuronSwitch #Bedrock #Anthropic #생성형AI #AI추론 #AI훈련 #3nmAI칩

티맥스티베로, 광주미래차모빌리티진흥원과 MOU 체결…V2X 기반 미...

티맥스티베로, 광주미래차모빌리티진흥원과 MOU 체결…V2X 기반 미...